31 Jul 2017

7 月 20 日,国务院发布了《新一代人工智能发展规划》,推动「以人类可持续发展为中心的智能化」,战略目标分三步走:

第一步,到 2020 年人工智能总体技术和应用与世界先进水平同步,人工智能产业成为新的重要经济增长点,人工智能技术应用成为改善民生的新途径,有力支撑进入创新型国家行列和实现全面建成小康社会的奋斗目标。

第二步,到 2025 年人工智能基础理论实现重大突破,部分技术与应用达到世界领先水平,人工智能成为带动我国产业升级和经济转型的主要动力,智能社会建设取得积极进展。

第三步,到 2030 年人工智能理论、技术与应用总体达到世界领先水平,成为世界主要人工智能创新中心,智能经济、智能社会取得明显成效,为跻身创新型国家前列和经济强国奠定重要基础。

总的目标是在「2030 年成为全球人工智能的领导者」。消息一出,国内企业欢呼雀跃,百度的老朋友吴恩达对此也持肯定态度,认为「其将切实有益于中国及全球的 AI 发展」。

不过,也有 Benedict Evans 等指出「从历史上看,这种产业政策对软件和知识产权非常不利,日本就曾做过同样的事情」。不同点在于,当时的日本正大力推进其「第五代计算机」计划,积极资助了各种 AI 项目,客观上促成了人工智能从「第一轮低谷」到「第二轮繁荣」的转折,而中国发布此规划的时机在「第三轮繁荣」的上升期。

另有一部分观点,对中国发展 AI 有着几方面的担忧:

- 数据保护主义,6 月份生效的网络安全法要求外国公司将收集的中国用户数据存在中国境内。不难想象,中国企业在国外也会受到同样的待遇(Tit For Tat)。如果不能汇集所有数据,那么无人车等各种AI产品上的算法可能就不会是最有效的。

- 关于技术伦理,西方的技术巨头已经承诺共同努力,确保他们开发的 AI 工具是安全的。这里既包括学术的公开,也包括讨论的公开。许多组织(如FHI、CSER/LCFI、MIRI、FLI、OpenAI、AAAI、IEEE、NSF、DARPA、PonAI等)都在进行 Beneficial AI 的研究。西方顶尖的 AI 人员在 2015 年签署了一封公开信禁止创建自动化武器,2017 年又进一步签署 Asilomar Principle,而中国相应的 AI 伦理的讨论是缺位或不透明的。

- 中国政府主导,规划关于 AI 对政府的价值是开放的,包括军事推演到智能监控。对政府的审查人员来说,AI 在模式识别中的价值可以很好地应用在对公民的维稳上。规划提到要「促进区块链技术与人工智能的融合,建立新型社会信用体系」,为人们的行为打分。这个模式一旦完善,相信会有很多专制政权会对此感兴趣。

如何判断这份规划带给中国的未来?让我们从「时间倒序」的角度,回顾一下近来发生的一系列事件。

纪念建军 90 周年阅兵

昨天,也就是 7 月 30 日,在朱日和举行了纪念中国人民解放军建军 90 周年阅兵。

对于在 21 世纪已经历过两次大阅兵的我们这一代,面对又一次阅兵似乎让人感觉「习以为常」,但这次阅兵确有不同之处。沙场阅兵的一系列特殊细节在此不一一赘述了,我想问的是,本次阅兵是给谁看的?

台湾、印度、朝鲜、日本、美国……结合不同事件,这些答案似乎都有道理。但我个人觉得,本次阅兵是为「攘外」,但更是为了「安内」。

其实,早在 2015 年,路透社援引某中共高层人士的话称,在习的任期上,阅兵将成为「新常态」,并给出了具体的阅兵日期:

- 2015 年 9 月 3 日,中国人民抗日战争胜利 70 周年纪念日;

- 2017 年 8 月 1 日,解放军建军 90 周年纪念日;

- 2019 年 10 月 1 日,新中国成立 70 周年纪念日;

- 2021 年 7 月 1 日,中国共产党成立 100 周年纪念日。

虽然当时被罗援少将否认了,称(1)、(3)是明确的,但(2)、(4)不符合常规,「在建军和建党纪念日举办阅兵,目前还没有先例」。

如今(2)已坐实,(4)看来更是不可避免。

在我看来,阅兵的目的,一方面可以向邻国发消息,加强国家爱国主义;另一方面,也是近几年来在国内反腐,特别是军队反腐背景下,习总为提升军队士气的,避免失控而采取的手段。

最终的结果,是强化了习总和党对权力的控制。

对 VPN 的清理整顿

7 月 29 日,中国多家 VPN 提供商陆续收到了来自苹果公司的通知,通知主要告知了这些提供商和开发者,他们的软件将从中国区 APP Store 中下架,因为这些软件包含了在中国不合法的内容。

30 日,苹果中国公司回应中国区 App Store 下架 VPN 应用一事称:「我们已经收到要求,在中国移除一些不符合规范的 VPN app。这些 app 在其他市场的运营则不受影响。」苹果中国称,今年年初,工信部出台了相关通知,要求所有提供 VPN 服务的开发者必须从主管部门获得经营资质。

中国加强对 VPN 的清理整顿已经有一段时间,工信部总工程师张峰表示,今年 1 月,工信部出台了《关于清理规范互联网网络结构服务市场的通知》,《通知》主要是为了更好地规范市场的行为,规范的对象主要是未经电信主管部门批准,无国际通信业务经营资质的企业和个人,租用国际专线或者 VPN,违规开展跨境电信业务经营活动。这些规定主要是对那些无证经营的、不符合规范的进行清理,对于依法依规的企业和个人不会带来什么影响。

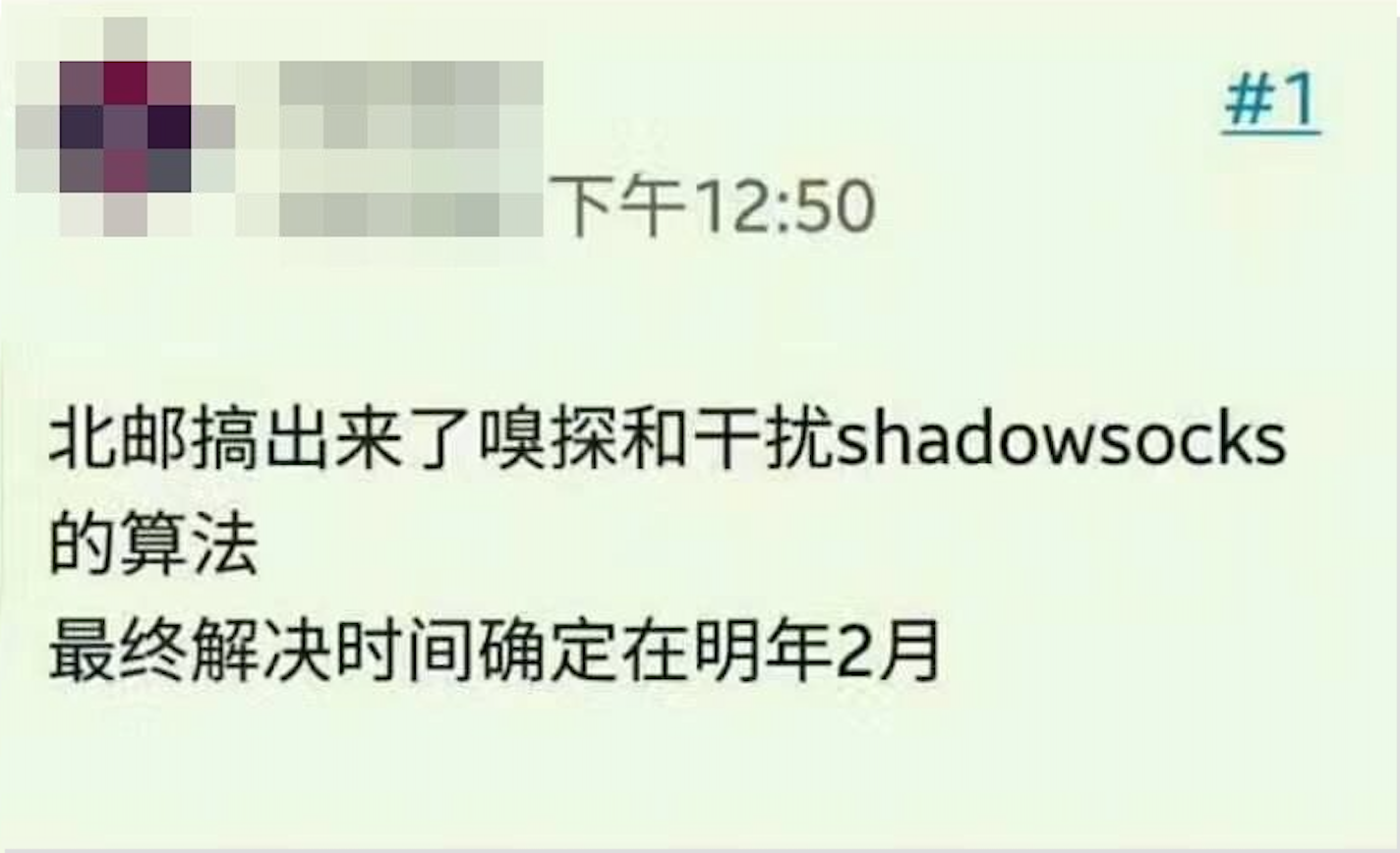

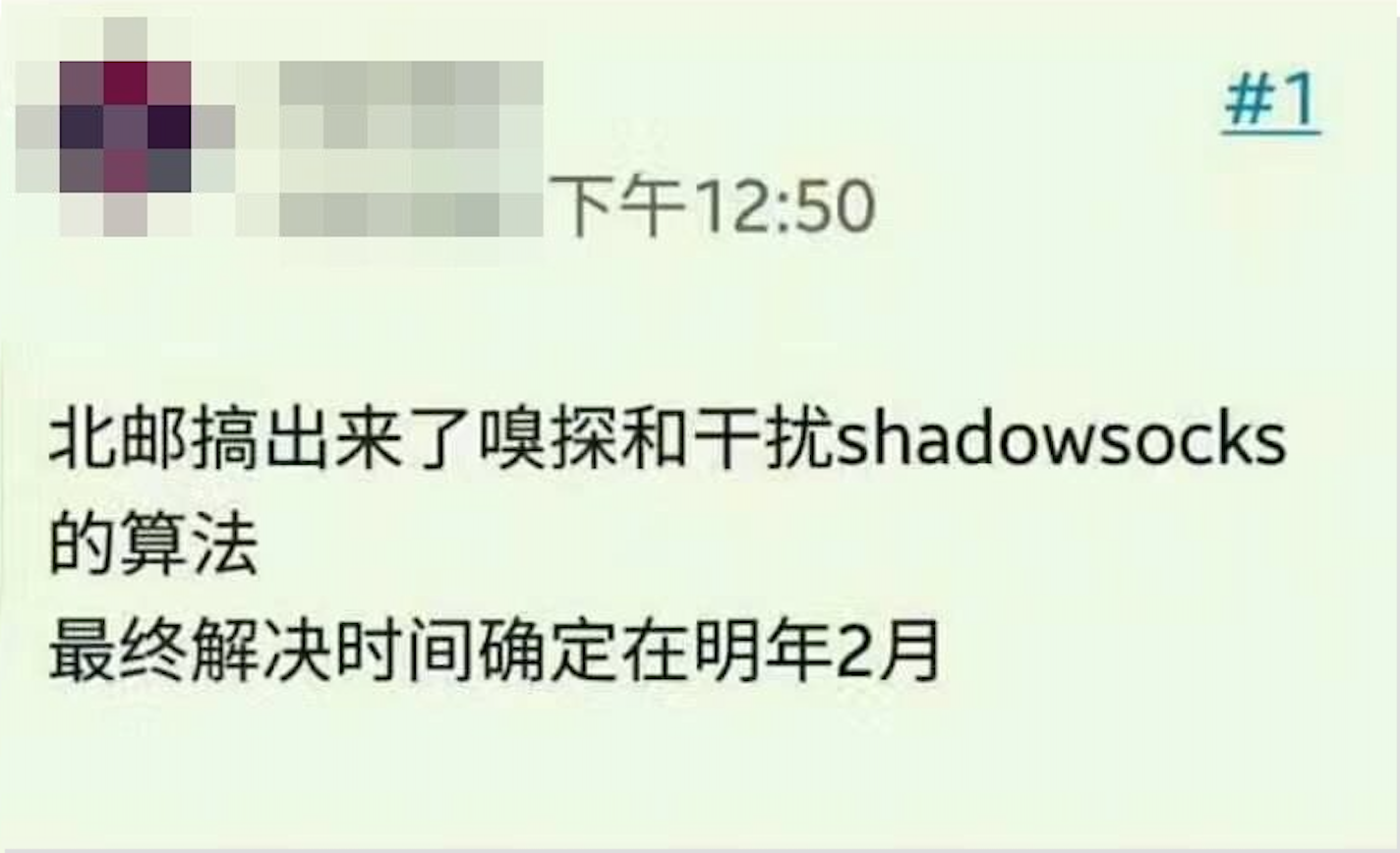

此外,专为突破网络封锁而开发的工具 Shadowsocks,也正进一步受到威胁:

总的来说,普通民众今后想要顺利的「翻墙」将越来越难,国家正一步步剥夺技术工程师赋予民众的信息自由的权力。

但为什么只封杀个人用户,而大企业对其拥有豁免权?

或许是因为,国家经济命脉不可动摇,个人信息自由可以牺牲。但加密技术如果今后只有依附于大企业才能使用,那将是对互联网精神最大的背叛。

诺贝尔和平奖得主去世

你要把他埋下,埋进土里,但你忘了,他是一颗种子。一粒麦子不死,仍是一粒麦子,一粒麦子死了,就会结出无数的子粒来。

——约翰福音 12:24

7 月 13 日,刘晓波去世。

根据维基百科:

2010 年,刘晓波获得挪威诺贝尔和平奖委员颁发的诺贝尔和平奖,成为首位或第二位(如果算上第十四世达赖喇嘛)获得该奖的中华人民共和国公民,也是继纳粹德国的卡尔·冯·奥西茨基(1935年)之后,第二例在服刑期间获得诺贝尔奖的人。刘晓波也是诺贝尔奖历史上唯一一位从获奖至辞世始终未能得到任何人身自由的诺贝尔奖得主。 2017 年 6 月,刘晓波因确诊患上为肝癌晚期而获准保外就医,其后于沈阳的中国医科大学附属第一医院在与外界隔离的状态下接受治疗。7 月 13 日 17:35,医院当局宣布刘晓波病情恶化并因多重器官衰竭,经抢救无效病逝,终年 61 岁。 他的遗体在 2017 年 7 月 15 日约 6 时 30 分(格林威治时间 2017 年 7 月 14 日晚上 10 时 30 分)火化,当天中午海葬。至今,外界无法与刘晓波的妻子取得联系。

刘的大哥表示,他从刘晓波病重到处理后事都有参与其中,也多次感谢共产党和中国官方的安排,认为安排体现了国家对刘氏家族的「人文关怀」。政府为刘晓波请来了来自德国和美国的医疗专家,安排出乎他的意料,「展视社会主义制度优越性」。特别提到,海葬是「家人意愿」。

「生不留人,死不留灰」。

从《美丽新世界》到《1984》

奥威尔担心我们憎恨的东西会毁掉我们,而赫胥黎担心的是,我们将毁于我们热爱的东西。

——尼尔·波兹曼

赫胥黎的《美丽新世界》和奥威尔的《1984》,描述的都是精英阶级的统治方式。尽管形式不同,但内核却异曲同工。

《美丽新世界》中的人们对一切漠不关心,而痴迷于琐碎的娱乐,这似乎是现代主义的必然。我们似乎都正在经历着这样的冲击,碎片化的时间、碎片化的信息、感官性的冲击、强迫性的消费……难怪尼尔·波兹曼认为,相对于《1984》里描述的一个等级森严的弥漫着恐怖气息的极权社会,我们更接近于《美丽新世界》,赫胥黎的预言正在实现。

但这是老大哥所期望的社会吗?或许这只是在当前技术手段下的一种选择上的妥协,而人工智能则带来了一种新的可能。分割、监控、预警……边沁的「圆形监狱」有望在 AI 时代得以实现。

一方面是政府权力的集中,一方面是个人自由的剥夺,我们正走向「反乌托邦」社会。如果中国真如国务院规划那般达到 AI 的世界领先水平,那么政府——而非人民——将会是最大的受益者。

26 Jul 2017

人工智能作为当前热门领域,充斥着太多「专家」和「洞见」。作为从业者,我们不希望人工智能又如前两次那样再次落入低谷,因此需要向公众传达尽量真实、准确的信息,近日看到纽约大学 Julian Togelius 教授的《Some advice for journalists writing about artificial intelligence》一文,深有感触,特翻译出来与大家共勉。

(题图来自 Geek Diaries)

(题图来自 Geek Diaries)

亲爱的记者朋友们,

当你撰写关于人工智能的文章时,我想就如何撰写得更好、更真实提供一些建议。我写这篇文章是因为在报纸和杂志上看到了太多关于 AI 的非常糟糕的文章。其中有一些毫无意义,近乎错误信息,另一些则捕捉到了一些信息,但充满了误解。不,我不会提供具体例子,但任何在 AI 领域工作并关注相应新闻的人都可以提供很多这样的例子。当然也有很多好的文章,但好/坏文章的比率显然存在改善空间。

首先,我能理解。你正撰写的是一个进展非常迅速的领域,充满了专业术语和有着宏大愿景的热情群体。考虑到所有这些兴奋,一定有很多可写的,但你对这个领域知之甚少(甚至一无所知)。你对 AI 的了解也许和我对制革厂的了解差不多。但是,制革厂演进得非常缓慢,涉及到非常具体的材料和工艺,AI 则在以惊人的速度发展,里面涉及到的词语很少是你能接触或是看到的实物。你有一种感触,必须把最新的进展在它们被取代之前现在就写出来,但很难看出从哪里可以破译出那些 AI 研究人员所描述的奇怪的东西。而且,你想要写一些可读性好、点击率高的东西,你又没有太多时间。这真的不容易。

所以,为了更关键和更高质量的 AI 报道,这里有一些需要谨记的事项,以及一些具体的建议。其中有一些是基于我在接受不同技术熟练度记者访谈时的经验,他们对我观点的接受程度也不一。是的,我们都在试图推销一些东西,就连我们这些象牙塔里的乖戾之人也在向你推销。更多内容下面会谈到。

谨记:AI 是一个大领域,用到了非常广泛的主题和方法。主要的 AI 会议(如 IJCAI、AAAI、ICML 和 NIPS)有成千上万的与会者,他们中的大多数其实只了解会议所讨论内容的一小部分。当我参加其中一项会议时,我也许能够跟上 20% 的演讲,并从中有所收获。我也许有些悲观,但很难发现有人能与广泛的子领域都保持同步,诸如约束传播(constraint propagation)、深度学习(deep learning)和随机搜索(stochastic search)。

建议:不要以为和你谈话的研究人员知道「当前 AI 的发展近况」。更重要的是,如果有人说他知道当前 AI 的发展近况,那么需要假设他们只是知道全局中的一小部分。需要向另一个 AI 领域的研究者进行再次确认(double check)。

谨记:没有所谓「一个人工智能」这样的东西。AI 是一套方法和思想的集合,可以构建软件实现一些人类大脑的功能。研发人员开发新的 AI 方法(并使用已有的 AI 方法)构建出令人印象深刻的软件(有时也包括硬件),诸如玩游戏或画猫。然而,你可以放心地假设同样的系统不能同时玩游戏和画猫。事实上,我还没有听说过基于 AI 的系统能做一系列不同的任务。即使是同样的研究人员,在基于同样的思想为不同的任务开发系统时,他们会构建不同的软件系统。当记者写下「X 公司的 AI 已经可以开车,但现在还可以写诗」时,他们掩盖了这些是不同系统的事实,似乎有些机器已经拥有了通用的智能。事实上并没有。

建议:不要使用「一个 AI」或「一个人工智能」这样的词。时刻要询问系统的局限是什么?例如,玩 Space Invaders 和 Montezuma’s Revenge 的是否用的同样的神经网络(提示:不是)。

谨记:AI 是一个古老的领域,很少有想法是真正全新的。当前,极好的但有些过热的深度学习的进步其实源于 20 世纪 80 年代和 90 年代的神经网络研究,而那些研究又是基于 20 世纪 40 年代以来的思想和实验。多数时候,前沿研究包含了许多方法的微小变化和改进,这些方法甚至产生于这些研究人员出生之前。反向传播,这种为当今大部分深入学习提供支撑的算法,已有数十年的历史,是由多人独立发明的。当 IBM 的「深蓝」战胜 Garry Kasparov,证明计算机比人类更擅长下棋时,软件的核心是 Minimax 算法,最初由 Alan Turing 在 20 世纪 40 年代首次提出。Turing,作为人工智能和计算机科学两大领域的先驱之一,在 1950 年发表了论文「论计算机器与智能」(On Computing Machinery and Intelligence)。虽然该文章最引人入胜的是图灵测试,但它也包含了人工智能许多关键思想的种子。

建议:阅读 Turing 1950 年的论文。它阅读起来相当轻松愉快,没有数学符号,任何技术术语也都可以被轻易忽略。令人惊叹的是,许多人工智能的关键想法已经就位,尽管当时还处于萌芽阶段。在撰写令人兴奋的新晋成就故事时,咨询一位老年或至少中年的 AI 研究人员。有些人在 AI 变冷之前已经开始了 AI 研究,或者甚至在它还没变冷之前,所以他已经面临过一次完整的 AI 炒作周期。有可能这个人可以告诉你这个新的进步是基于哪个旧的想法所做的(轻微)改进。

谨记:研究人员总有一些想要推销的东西。显然,那些从事某种创业活动的人正在寻求增加公司估值以及被投资或收购的机会。那些学术界的人在寻求演讲邀请、引用和晋升等等。那些在大公司工作的人则希望对某些可能与实际结果有关或无关的产品感兴趣。

建议:不要相信炒作。接触一下其他研究人员,那些你正撰写的人没有向你引荐的,询问那个人是否相信他们的主张。

谨记:多数「人工智能」实际上是人类的聪明才智。研发人员专注于针对特定领域(例如机器人、游戏或翻译)开发 AI 应用是有原因的:当构建系统来解决问题时,系统中包含了许多关于实际问题的知识(「领域知识」)。这可能包括向系统提供特殊输入,使用特殊准备的训练数据,手工编码部分系统,甚至重构问题以使其更容易。

建议:若想理解一个「AI 解决方案」的哪个部分是自动的,哪一部分是由高明的人类领域知识编码而来的,一个好方法是询问这个系统在一个略微不同的问题上将会有何种表现。

我的这篇文章最好到此为止,因为现有的文字可能已经听起来有太多抱怨。看,我并没有抱怨,我甚至几乎已经老了。我并不想给人留下现在的 AI 并没有多少令人兴奋的进步的印象。事实上,有足够多的真正进展可供报道,我们并不需要以旧充新的衍生研究来拼凑报道。让我们试着诚实、关键和准确,好吗?

24 Jul 2017

周五坐公交车上班的路上,在马连洼附近看到这么一幅标语「科技小清新 文化一家亲」,一时有些茫然。

「小清新」一词见得很多,但什么是「科技小清新」?带着疑问我上网搜了搜,发现这是海淀区为「创建国家公共文化服务体系示范区」征集而来的宣传口号,属于获奖作品,但没有给出解读。

那么我就来谈谈我对「科技小清新」的看法。

1. 什么是「小清新」?

根据维基百科:小清新,由清新一词而来,最初与一类清新唯美,曲风温和、多为音乐人独立创作的音乐风格绑定,之后随网络及文艺青年群体的扩大,使用范围扩散到文学、电影、摄影、衣着、设计等文艺领域。

作为形容词所指的小清新风格,八九十年代文化解禁,港澳台、日本、欧美文化进入中国后便已出现,在日本,台湾出现得更早,只是彼时小清新一词尚未流行,一般用重叠度较高的小资一词表示。现小清新一词逐渐成为名词,指代这一文化现象或有此文化偏好可能的人群。

文学、电影、摄影、独立音乐这类标签基本已标识出小清新属于社会中上层,受过良好教育,生活压力较小,生活水平较高的人群,很大程度成为侧面反映年轻人社会地位的标签。

不过「小清新」+「科技」,怎么看都是一种比较奇妙的组合。

2. 如何理解「科技小清新」?

我愿意把「科技小清新」理解为一种在科技产品上追求轻松与温润的态度。

从 UX 上,她是一种温润如玉的设计,不能让人直面一种冷冰冰的算法。用户需要的不仅仅是结果,还需要呈现结果的过程。多数时候用户凭直觉就能知道如何进行交互,发现未曾知晓的新交互时会微微一笑,回应开发者一份「你懂我」的赞许。

从 UI 上,她是一种如沐春风的唯美,而且必须跟上时代。从早期 iOS 的Skeuomorphism(拟物化),到 Google 力推的 Material Design,再到 Low Poly 等流行设计时尚,小清新一定会是最早尝试的一批。她会紧跟时尚,但她不会创造时尚,因为小清新的本质是一种「冷淡」。

3. 「小清新」有自己的态度吗?

小清新的「冷淡」更多体现在「选择」上,必须恰如其分,不多、不少、不增、不减、不快、不慢、不温、不火。

但与此同时,她们又拒绝了现实中存在的更多选项,比如 Siri 的笨拙、Chrome 的极简、今日头条的冰冷、A 站的中二……面对这些优秀的产品,她们或是「事不关己」地进行选择性无视,又或是「自我安慰」地认为存在即合理。能认可大家的不同,也能接受大家的不同,这是小清新唯一的态度。

小清新从本能上最反感的一个词是「强度」,因为它不仅意味着「程度」,也意味着「投入」。乔布斯的「不同凡想」是需要强度的,科比的「曼巴精神」是需要强度的,李小龙的「武道实践」是需要强度的,原研哉的「素手时然」也是需要强度的。

小清新在给予自己这个标签的同时,也把放弃努力这一姿态合理化。

4. 你是否会选择「科技小清新」?

生活上的小清新是一种个人选择,无可厚非;但如果工作上也采取这样一种态度,那么就很难指望能产出高质量的作品。

不过,以 BAT 为代表的互联网科技公司,似乎还在鼓励这种态度。对员工无微不至(行政在员工面前给人低人一等的感觉)、提供各种福利(衣食住行,各种你能想到和不能想到的 perks)、弹性工作时间(中午十二点以后才到公司的大有人在),希望员工的一切后顾之忧都能被公司解决,只要你能好好地在公司干活。

这一文化的始作俑者是 Google,美其名曰「fun culture」。在前 CEO Eric Schimidt 的著作《How Google Works》(中文版译名《重新定义公司——谷歌是如何运营的》)中,还专门解释道他们讨厌大写的「Fun」,那意味着一种「常规化」的娱乐活动,比如年会。相反,小写的「fun」是一种无时无刻、无处不在的存在,可以随时和领导、同事开各种玩笑,核心是只要你能 Enjoy Yourself。

不过,我认为「fun culture」是容易滋养出「小清新」人格的,这种生活态度一旦蔓延到工作领域,那么对于公司来说无异于一种慢性自杀。某种程度上,「fun culture」对员工来说其实也是一种残忍,由俭入奢易、由奢入俭难,如果离开了互联网,他们究竟还能适应哪种工作?

一开始你会爱它,享受它给你带来的所有;接着你会慢慢的习惯它,熟悉它;最后你会离不开它,离开它你将不知所措。现在,你还会觉得利用「fun culture」将员工「institutionalized」(体制化)是一种道德吗?

20 Jul 2017

Elon Musk 最近又在谈 AI 对于人类的潜在威胁了,我并不否认这项议题的重要,但它容易让我们忽略 AI 更短期的影响,比如大规模自动化,以及对工作的替代。

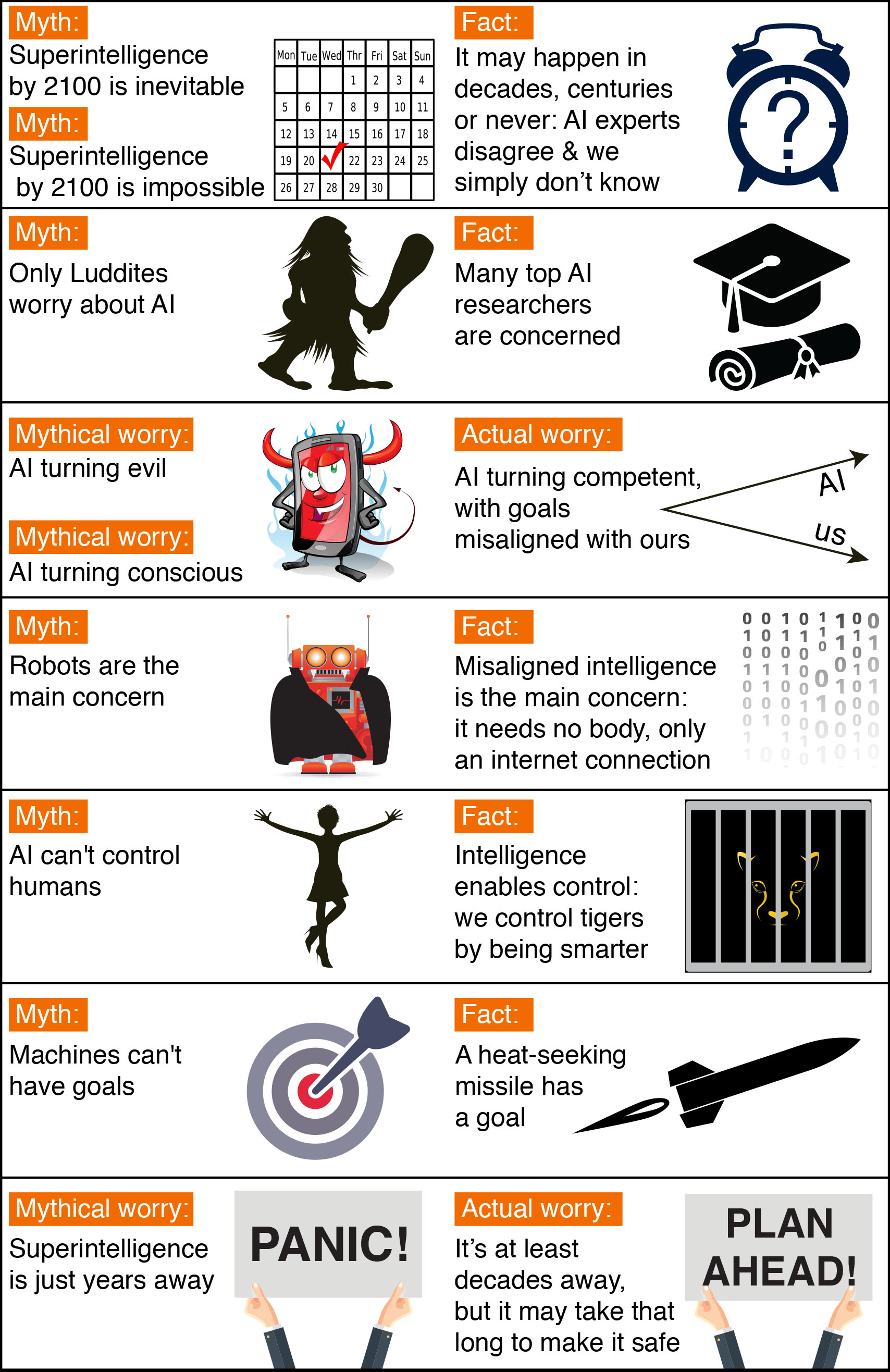

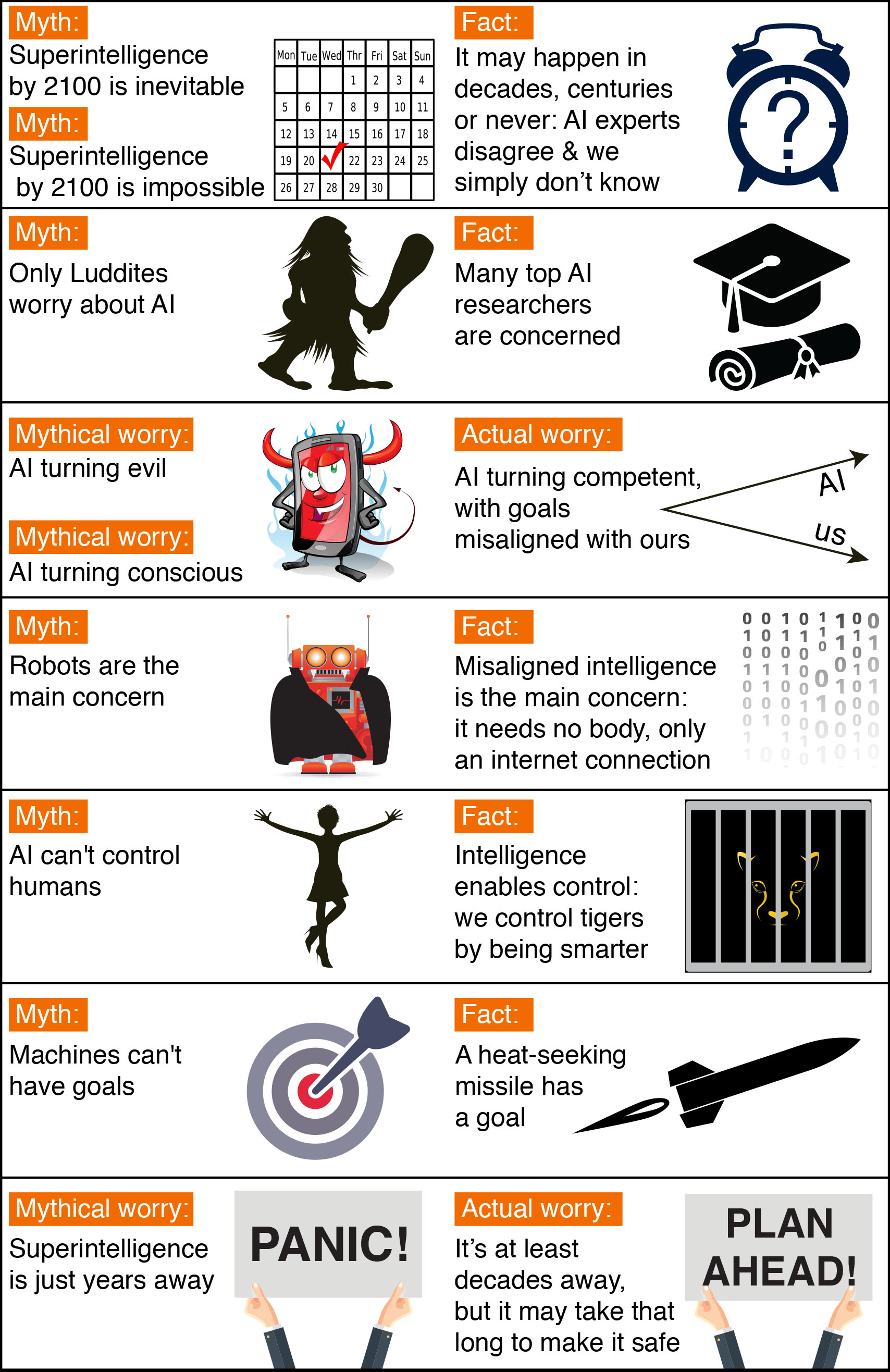

在 AI 问题上,部分议题确有争论,就连顶尖科学家都没有达成共识,但也有很多议题属于不必要的争议,或者说是公众对其的迷思。FLI 对此进行了很好地概括,我试译如下:

1. 时间推断上的迷思

第一个迷思与时间相关:机器需要多久能全面地超越人类智力?一个通常的错误观念是我们能精确地对此进行推断。

通常,人们误认为我们肯定能在本世纪内实现超级人工智能。事实上,人类历史上充满了对技术的高估。比如,从前人们认为一定会实现的聚变发电厂和飞行汽车,现如今却从未出现过。而 AI 在历史上,也一再地被高估,包括这个领域的先驱们。比如,John McCarthy(「人工智能」一词的提出者)、Marvin Minsky、Nathaniel Rochester 和 Claude Shannon 就曾写下过于乐观的预测,利用当时笨拙的电脑 2 个月时间就能完成:「我们计划进行 2 个月、10 人在达特茅斯学院的人工智能研究……试图了解怎样让机器使用语言,形成抽象和概念,解决目前只有人类能解决的问题,并让其自我改进。我们认为,只要有一组精心挑选的科学家一起工作一个夏天,就能在某些问题上取得重大进展。」

另一方面,与之相对的极端迷思是我们肯定不能在本世纪内实现超级人工智能。研究人员就我们离超级人工智能的时间差距做了广泛的估计,但我们没法确定这一概率在本世纪内为 0,因为过去种种对科技持怀疑的预测往往都是错的。比如,当时伟大的核物理学家 Ernest Rutherford 曾在 1933 年断言,利用核能是「妄想」(moonshine),但不到 24 小时,Szilard 就发明了链式反应。另外,皇家天文学家 Richard Woolley 在 1956 年称星际穿越是「胡说」(utter bilge)。关于 AI 最为极端的迷思是超级人工智能永远不会实现, 因其在物理上就是不可能的。然而,物理学家们知道,大脑是由夸克和电子组成的强大计算机,没有任何定律规定了不能由其构成更为强大的智能。

当前已经有一系列调研询问 AI 研究者他们认为需要多少年实现人类级别的 AI 能达到 50% 的概率。所有这些调研得到了同样的结论,顶尖科学家都无法达成共识,更不要说我们了。比如,在 2015 年的波多黎各的 AI 大会上,平均(中位数)是 2045 年,但也有学者预测需要几百年。

还有一个相关的迷思是人们担心超级人工智能在几年内就会实现。事实上,多数人对超级人工智能的预测都发生在几十年以后。但他们认为,只要我们不是 100% 确定超级人工智能不会在本世纪内发生,最聪明的做法就是现在便开始进行安全研究,以防范于未然。许多与人类级别 AI 相关的安全问题非常难,可能需要几十年才能解决。所以,与其等到一群喝着红牛的程序员不小心启动问题前才做出对策,现在就开始针对这些安全问题进行研究是明智的。

2. 争议的迷思

另一个常见的误解是,那些对 AI 感到担忧,提倡 AI 安全研究的都是些不懂 AI 的卢德分子(Luddite),当 Stuart Russell,AI 标准教科书的作者在其波多黎各的演讲中举出这个例子时,观众们大笑不已。与之相关的一个误解是,支持 AI 安全研究有巨大争议。事实上,对 AI 安全研究的适当资助,并不意味着其风险很高,只是因为其不容忽视。就像为房屋购买适当的保险一样,是因其被烧毁的可能性不容忽视。

看起来,媒体使得 AI 安全问题看起来比实际上更具争议。毕竟,恐惧有市场,用夸张引言宣扬迫近的危机比言辞谨慎的平衡报告更容易引来点击率。因此,借由媒体来了解相互立场的两人,可能会认为他们的分歧比实际上更为严重。比如,技术怀疑主义者读了 Bill Gates 在英国小报中表达的观点,或许会误认为 Gates 相信超级人工智能即将来临。类似的,beneficial-AI(有益的人工智能) 运动中的某些人在对 Andrew Ng 的立场不太了解前,就因为他对火星人口过多的发言而错误地认为他不在乎 AI 安全问题,而事实上,他确有关心。关键点在于,Andrew 对时间的推断较长,因此他更倾向于优先解决短期内而非长期中面临的挑战。

3. 对超级人工智能风险的迷思

许多 AI 研究者看到这个头条时都不以为然:「Stephen Hawking 警告机器人的崛起可能给人类带来灾难。」因为许多人已经看过很多类似的文章了。典型的,这些文章会描述携带武器的邪恶机器人,并建议我们应该对机器人的崛起以及杀戮人类表示担忧,因为它们已经变得有意识和/或邪恶。乐观地看,这些文章其实相当有吸引力,因为他们简洁地总结了 AI 研究者从不担心的问题。这一场景结合了三种独立的误解:关于意识、邪恶和机器人。

如果你行驶在路上,你会对颜色、声音等有主观体验。但一辆自动驾驶汽车会有主观体验吗?它是否会觉得自己就像一部自动驾驶汽车?尽管这种关于意识的神秘本身很有趣,但它与 AI 的风险无关。如果你被无人车撞到,它是否拥有主观意识对你没有任何区别。同样,对我们人类的影响来自超级人工智能做了什么,而不是它的主观感受。

对机器人变得邪恶的恐惧是另一个无关话题(red herring)。真正需要担忧的不是恶意,而是能力。根据定义,超级人工智能非常善于实现其目标,无论这些目标是什么,所以我们需要保证它的目标和我们人类的目标一致。人类并不是都讨厌蚂蚁,但我们比它们更智能,所以如果我们想修建一座水电站但有一个蚁丘在哪,这对蚂蚁来说就不太妙了。beneficial-AI 运动希望避免人类被置于那些蚂蚁的处境中。

对于意识的误解与机器不能拥有目标的迷思相关。机器显然在狭义上拥有实现其目标行为的目标:热追踪导弹的目标可以从经济上解释为击中其靶位。如果你感觉受到了来自和你目标不一致的机器的威胁,那么真正困扰你的是它被设置的狭义的任务。如果那个热追踪导弹正追逐着你,你大概就不会惊叫:「我并不担心,因为机器本身没有目标!」

我同情 Rodney Brooks 以及其他被小报不公平地妖魔化的机器人先驱,因为一些记者过分痴迷于机器人,并且在很多文章中用闪着红色双眼的邪恶金属怪物来刻画它们。事实上,beneficial-AI 运动关注的并不是机器人,而是智能本身:特别是那些与我们目标不一致的智能。若要给我们带来麻烦,这些超级人工智能其实并不需要机器人的躯体,而只需网络连接即可,如引发超出控制的金融市场,取代人类研究者的创新能力,超越人类领导人的掌控力,以及开发出我们甚至都不能理解的武器等。就算建造机器人在物理上是不可行的,一个超智能、超富有的 AI 可以轻易用金钱支付或是操纵许多人类无意识地听命于它的指示。

对机器人的误解与机器不能控制人类的迷思相关。智能可以实现控制:人类可以控制老虎并不是因为我们更强壮,而是因为我们更聪明。这意味着如果我们从我们星球上智慧巅峰的地位上退去,我们有可能也失去了控制力。

4. 有趣的争议

与其把时间浪费在上述误解中,不如让我们聚焦于那些真实而有趣的,就连专家们都无法形成共识的争议上。你希望拥有什么样的未来?我们是否应该开发致命性的自动武器?你希望通过工作自动化带来什么?你将会给当今的孩子传递什么职业建议?你是喜欢一个新工作替代旧工作的社会,还是一个无需工作人人皆可享受生活而由机器来创造财富的社会?不久的将来,你是否希望我们创造出超级智能的生命并将其传播到我们的宇宙中?是我们来控制机器还是机器来控制我们?智能机器是会替代我们,还是与我们融合?在人工智能时代,作为人类意味着什么?你希望人类拥有什么样的意义,我们如何才能实现那样的未来?欢迎加入讨论!

18 Jul 2017

在 Quora 上,Alan Kay 回答了一个问题:「What was it like to be at Xerox PARC when Steve Jobs visited?」

读来颇为有趣,总结下来有以下三点:

- 在 Jobs 看到 Alto(第一台基于 GUI 的计算机)和 Smalltalk(面相对象编程语言)之前,其实已经有几百万人看过它们了。一方面,是因为 PARC 相对开放;另一方面,则是因为相关文章已经被发表在了科学美国人(Scientific American)等杂志上。那么,我们是该赞叹 Jobs,还是该让其他人面壁呢?

- Jobs 太过被 GUI 吸引,以至于忽略了同时展示给他的另外两个重要产品,有多重要?它们分别是以太网(Ethernet)和面向对象编程(object-oriented programming),所以你懂的……

- 就算被惊艳到且不吝赞美,Jobs 还是会说「还不够完美」(but it was flawed and incomplete),这也是他在不是屋子里最聪明的人却又想表现得顶尖(top gun)时的常用办法。

(题图来自

(题图来自