24 May 2022

1 建设性游戏 vs 破坏性游戏

围棋 vs 象棋

开始思考这个问题,是缘于Demis Hassabis谈论AlphaGo时,提到围棋与国际象棋的区别:

围棋是一种建设性的游戏,所以棋盘开始时完全是空的,你一步一步地建立形势。 因此,如果你要在游戏中途或开始阶段尝试评估一个形势,这非常困难,因为它涉及对未来可能发生的情况的大量预测。 如果你将其与国际象棋进行对比,国际象棋是一种破坏性的游戏,所有的棋子开始时都在棋盘上,随着你走向残局,实际上游戏变得越来越简单。

这让我第一次从此视角看待两种棋类的区别,也让我思考这种差异对棋手思维方式的影响。

相较于象棋,围棋更看重高效占领和攻守平衡,而非攻杀和摧毁对手。

大局观

棋类比赛中,我们经常听到讲解者提到某某棋手「大局观」好,那么大局观是什么?

我理解的「大局观」,是一种对棋局发展的整体把握,对子力配置、争夺焦点、棋局走向的综合判断。这种判断需要棋手对于棋局的理解要达到相当的深度,对「棋道」有较深的感悟。在变化的棋局中,不但要运用战术能力进行精确计算,更要用战略眼光进行形势判断。不拘泥于一子一地的得失,而是以最终胜利为目标持续趋近。

因此,棋类比赛,娴熟的技战术只是基础,最终比拼的是棋手的世界观。

战略思维

世界观会影响棋局,同样棋局会影响世界观。

马凯硕在他的《中国的选择》中曾提到,2018年Henry Kissenger在纽约的一次午餐会上谈到围棋及其策略时启发了他:

中国的战略是以围棋的思维,而非西方的国际象棋思维为指导的。下国际象棋,重点是找到最快的途径来俘获国王。下围棋,则要致力于慢慢地,耐心地积累资产,以打破游戏的平衡,使局势变得利于己方。

毛泽东在《中国革命战争的战略问题》、《抗日游击战争的战略问题》等名篇中,曾多次使用围棋进行类比,如:

八路军、新四军向敌后进军,与日军的攻势形成了包围与反包围的关系,这种你中有我、我中有你的犬牙交错的状况,就好像是下围棋。

敌我各有加于对方的两种包围,大体上好似下围棋一样,敌对于我我对于敌之战役和战斗的作战好似吃子,敌之据点和我之游击根据地则好似做眼。

回过头看当今的中美全面博弈,你是否能感受到此中的思维模式差异?

2 建设性沟通 vs 破坏性沟通

这里的沟通,包括对话、批评、冲突等。

沟通的目标,通常是为了被接收、被理解 、被接受,甚至使对方有所行动。

如何区分建设性冲突与破坏性冲突?

在我看来,存在以下区别:

| 建设性冲突 |

破坏性冲突 |

| 关心共同目标 |

关心自己胜利 |

| 以事实为主,对事不对人 |

以观点为主,含人身攻击 |

| 提供改进建议 |

没有改进建议 |

| 具体、明确、详细、可操作 |

模糊、不具体 |

| 产生动力、能量,促进沟通 |

产生防御、疲劳,阻碍沟通 |

而我们应该如何去主动创造建设性的沟通呢?有两个原则给了我很大启发。

对话守则:如何避免无意义的争论

一个是在中文世界流传较广的捷克公民论坛的《对话守则》:

- 对话的目的是寻求真理,不是为了斗争。

- 不做人身攻击。

- 保持主题。

- 辩论要用证据。

- 不要坚持错误不改。

- 要分清对话与只准自己讲话的区别。

- 对话要有记录。

- 尽量理解对方。

拉波波特法则:批评他人的正确方式

另一个,则是在《直觉泵》中读到的《拉波波特法则》。

- 你应该非常清楚、生动、不偏不倚地重述对手的想法,使得你的对手说:「谢谢你,我刚才要是像你这么表述就好了。」

- 你应该把对方观点中你所同意的部分都列出来,尤其是那种并非被人们广泛接受了的观点。

- 你应该提到那些从你对手那里学到的东西。

- 只有完成了以上三点,你才能说一句反驳或批评的话。

遵循此法则的一个直接的好处就是,你的对手会因此乐于倾听你的批评。因为他们看到你已经站在他们的立场上理解了他们的想法,同时你也展示出了良好的判断力,在一些重要的事情上和他们达成了共识,甚至在有些地方还被他们说服了。

对于那种讽刺对手的恶习,这套规则是最好的解毒剂。

根源

建设性的沟通,需要双方都保持理性,并掌握适当的沟通技巧,而破坏性沟通大多是因为双方的情绪或态度失控而导致的。

3 建设性创新 vs 破坏性创新

此处的「破坏性创新」,并非是指Clayton Christensen教授的Disruptive Innovation(常被译为破坏性创新/颠覆式创新)。

也不是马云提到的「我们不是破坏性创新,我们是建设性创新」,他所指的建设性创新更接近于面向新市场的架构创新或激进创新。

而我想说的建设性创新和破坏性创新,是一种博弈或可持续发展视角的创新。

创新政策的收益矩阵

|

|

整体 |

|

|

胜 |

负 |

| 自身 |

胜 |

好的 |

丑陋的 |

| 负 |

自损的 |

坏的 |

以国家为例,各国的国家创新战略涵盖广泛的个别政策领域,包括技能、科学研究、信息和通信技术、税收、贸易、知识产权、政府采购、标准和法规。各国对这些政策的实施可以以正和、零和或负和的方式进行。

如上表所示,创新政策可以从四个不同的定性角度之一实施,其方式是:

- 同时使本国和他国/世界受益(好的)。

- 以他国/世界为代价让本国收益(丑陋的)。

- 本国和他国/世界都不能收益(坏的)。

- 并未使本国受益,但使他国/世界受益(自损的)。

理想情况下,为确保开放的国际贸易体系的可持续性以及全球GDP的最大增长,所有国家都需要朝着制定同时有利于自身和全球体系的双赢创新迈进。但实际上,各国在许多情况下选择的发展路线和政策工具却并非如此。

(未完待续……)

20 May 2022

自图灵的假想纸带机之后,计算机所有方面的改善,提高的都只是运算速度。

— 丹尼尔·丹尼特

什么样的科技突破会让你感到惊艳,情不自禁喊出一声「哇塞」?

也许有人会说,是那些把科幻带入现实的。

不过在我看来,是那些让人没想到能做到,或是没想到现在能做到的。

以AI领域为例,GPT-3、AlphaFold 2、DALL·E 2等前沿AI拓展了AI领域以及其他领域的可能性。

这些突破性创新的关键,我觉得不是找到了正确的答案,而是找对了问题,或者说是「思考不可想象之事」(Think the Unthinkable)。

苏联在美国之后几年就造出了原子弹,AlphaGo之后迅速出现多个围棋AI,近年出现的无人驾驶和AI芯片风潮等。

没有方向,不知道能否做出来时,谁也不敢发力投入。

但一旦有人做出来了,就算仅仅知道这个方向是可行的,这也是最重要的信息。

期待更多原始创新。

20 May 2022

AI的风险分析是AI伦理与治理的关键前置环节,我的态度是不低估、不夸大、客观研究、积极应对。

1 分析维度

- 产生原因:事故风险、滥用风险、结构风险

- 产生方式:算法、数据、应用

- 时间范围:近期、远期

- AI能力:ANI、AGI、ASI

- 持续时长:即时、长期

- 影响程度:小影响、中影响、大影响、极端影响

- 确定程度:小概率、中概率、大概率

- 生命周期:研发、供应、使用

- 特定风险:需具体模型具体分析

- ……

2 维度解读

2.1 产生原因

从因果链的角度,分析产生风险的各种直接和间接原因。可能包括:

- 事故风险(Accident risks):AI系统异常行为的危害。

- 如AI对环境的误解从而导致自动驾驶汽车的事故。

- AI越来越多地被嵌入到安全攸关的重要系统中,如车辆和能源系统,事故的潜在成本提升。

- 应对:增强鲁棒性、保证性、规范性等。

- 鲁棒性(Robustness):确保系统即使在不熟悉的环境中也能继续在安全范围内运行。

- 保证性(Assurance):确保它可以被人类操作员轻松分析和理解。

- 规范性(Specification):确保其行为符合系统设计者的意图,如更先进AI系统的价值对齐(Value Alignment)问题。

- 滥用风险(Misuse risks):人们以不道德的方式使用AI的可能性。

- AI的双重用途性质(Dual-use) ,如Deepfake,可能被用于政治干扰或钓鱼攻击。

- AI和自主机器的进步激发了人们对自动化武器的担忧。

- 应对:出版前审查,以及其他可能阻止不道德行为者获得或使用强大AI功能的措施;OpenAI,分阶段开放+合作伙伴共享。两种方式对 GPT-2 模型进行开源;国外主要云服务商,陆续不再提供通用人脸识别API。

- 结构风险(Structure risks):环境和激励机制被技术微妙塑造而产生的风险。

- 滥用风险、事故风险及相关的治理政策,都只聚焦了影响因果链的最后一步。

- 过去:第一次世界大战中,铁路等技术,即使没有被故意滥用,也可能产生深远的负面影响。

- 当前:核战略稳定、垄断市场、劳动力转移、隐私侵犯等。

- 应对:增加结构视角,政策干预的机会也会更大。

2.2 产生方式

数据和算法也是当前AI治理的重点治理对象:

2.3 时间范围

可能存在多种维度:

- 被认为是「近期」的问题往往是由于当前/可预见的AI系统和能力而在当前/不久的将来出现的问题,其规模/严重程度各不相同,主要对人类和社会产生直接影响。

- 被认为是「长期」的问题往往是由于AI能力的巨大进步(特别关注TAI或AGI)而在遥远的未来出现的问题,以及那些可能构成风险的问题是严重的/大规模的,具有非常长期的后果。

2.4 AI能力

是关注当前AI系统的影响和挑战,还是更先进AI系统造成的影响和挑战。从能力、影响、速度的维度看:

- Artificial Narrow Intelligence (ANI)

- 擅长单一领域,或超越人类

- 意味着工作增强

- 当前AI在部分领域已达成

- AGI Artificial General Intelligence (AGI)

- 在所有任务都可与人类匹敌

- 意味着工作被替代的风险

- 也许几十年后达成

- ASI Artificial Super Intelligence (ASI)

- 在所有任务都远远超越人类

- 意味着人类被替代风险

- AGI之后很快达成

2.5 持续时长

是主要关注AI对社会的即时和直接风险,还是考虑未来可能产生的风险。

- 即时风险(Immediate risks):意味着短期内就能看到产生影响,但是否需迫切应对需要看影响程度和持续时长。

- 长期风险(Long-lasting risks):意味着持续积累作用于未来影响,对人类社会的影响可能更为深远。

2.6 影响程度

是关注所有规模的风险,还是优先关注那些规模可能特别大的风险。其中:

Existential risk(生存性风险,X-Risk)是牛津大学Nick Bostrom于2002年提出的概念。他将其定义为:「生存性风险是威胁起源于地球的智能生命过早灭绝或对其未来发展潜力的永久和剧烈破坏的风险。」

X-Risk划分为四级,是与广义的技术成熟度联系起来加以定义的:

- 人类灭绝(Bang):源自地球的智能生命在相对突然的事故或蓄意破坏导致的灾害中灭绝。

- 永久停滞(Crunches):尽管人类以某种形式继续存在,但人类发展为后人类的潜力永远受到阻碍。

- 有损实现(Shrieks):某种形式的后人类已经实现,但它受限于可能和可取带宽的极小范围。

- 后续毁灭(Whimpers):后人类文明出现了,但其发展方向逐渐但不可逆转地导致我们所珍视的事物完全消失,或者导致这些事物的实现仅达到本可实现的极小程度。

Toby Ord在《The Precipice》中对生存性风险也做了估算,与未对齐的AI相比(1/10概率),其他的生存性风险都相形见绌。

| Existential Catastrophe Via |

Chance within the next 100 years |

| Asteroid or comet impact |

~ 1 in 1,000,000 |

| Supervolcanic eruption |

~ 1 in 10,000 |

| Stellar explosion |

~ 1 in 1,000,000,000 |

| Total natural risk |

~ 1 in 10,000 |

| Nuclear war |

~ 1 in 1,000 |

| Climate change |

~ 1 in 1,000 |

| Other environmental damage |

~ 1 in 1,000 |

| ‘Naturally’ arising pandemics |

~ 1 in 10,000 |

| Engineered pandemics |

~ 1 in 30 |

| Unaligned artificial intelligence |

~ 1 in 10 |

| Unforeseen anthropogenic risks |

~ 1 in 30 |

| Other anthropogenic risks |

~ 1 in 50 |

| Total anthropogenic risk |

~ 1 in 6 |

| Total existential risk |

~ 1 in 6 |

(图表引自The Precipice)

欧盟人工智能法案的分类类似:极小、有限、高、不可接受,但不可接受与X-Risk概念并不相同

- 极小风险,提供简单工具性功能的AI系统。

- 有限风险,具有特定透明度义务的AI系统。

- 高风险,可能危及公民人身安全及生活基本权利场景中的AI系统。

- 不可接受,对基本人权和社会公平构成明显威胁的AI系统。

2.7 确定程度

是关注相对确定且易于理解的问题和风险,还是更不确定的问题和风险。

- 确定也意味着更易于理解和聚焦。

- 吴恩达曾说过,他不关心更先进AI的原因与「我不担心火星上人口过剩的原因是一样的……我们从未踏上过这个星球,所以我们现在怎么能有效地担心这个问题呢?」

- 长期风险、生存性风险、更先进AI系统造成的风险,则都有很大的不确定性和推测性。

- 那些关注AI生存性风险的人,往往批评吴恩达的这类想法过于投机,并且「分散了人们对当今AI真正问题的注意力」。

2.8 生命周期

关注单点风险,还是全生命周期风险。

-

各阶段的风险包括

-

研发阶段:关注自律意识、数据质量、安全透明、避免偏见等。

-

供应阶段:关注市场规则、质量控管、用户权益、应急保障等。

-

使用阶段:关注提倡善意、避免滥用、禁止恶用、主动反馈等。

-

全生命周期

- 从负责任AI的角度,需要伦理道德融入人工智能全生命周期,从整体视角考虑各个阶段的风险。

2.9 特定风险

需具体模型具体分析,如:

- 语言模型的毒性/偏见。

- 图片生成模型的色情/暴力。

- 基础模型的风险继承等。

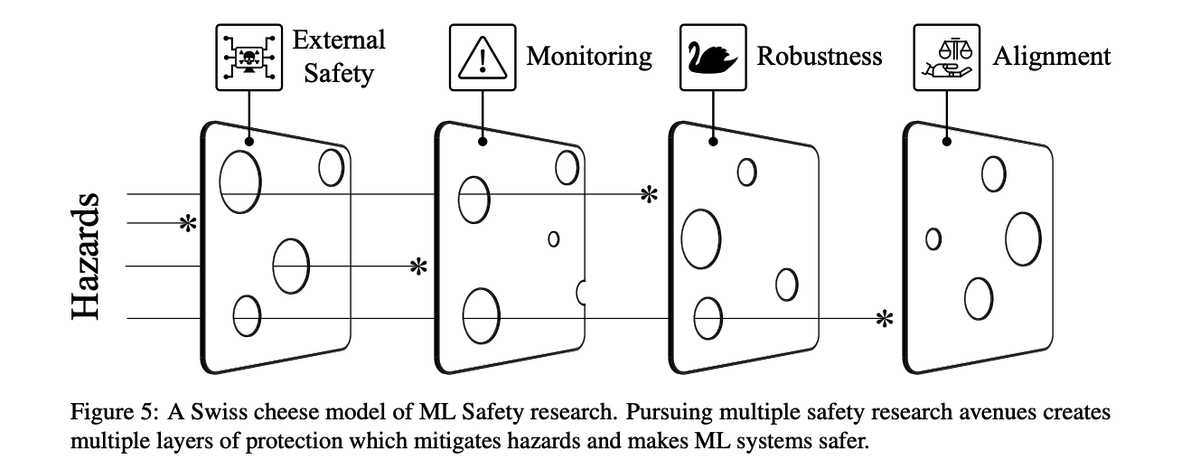

3 易被忽视的方面

3.1 单一维度

- 产生原因:价值对齐(Value Alignment),AGI Safety领域最难的问题之一(易被忽视)

- 一方面,如何将人类的价值观赋予AI,这是一个技术问题。

- 另一方面,选择何种价值观赋予AI,这是一个社会问题。

- 在其他安全手段都失效的情况下,价值对齐也许也是人类最后一层保护伞。

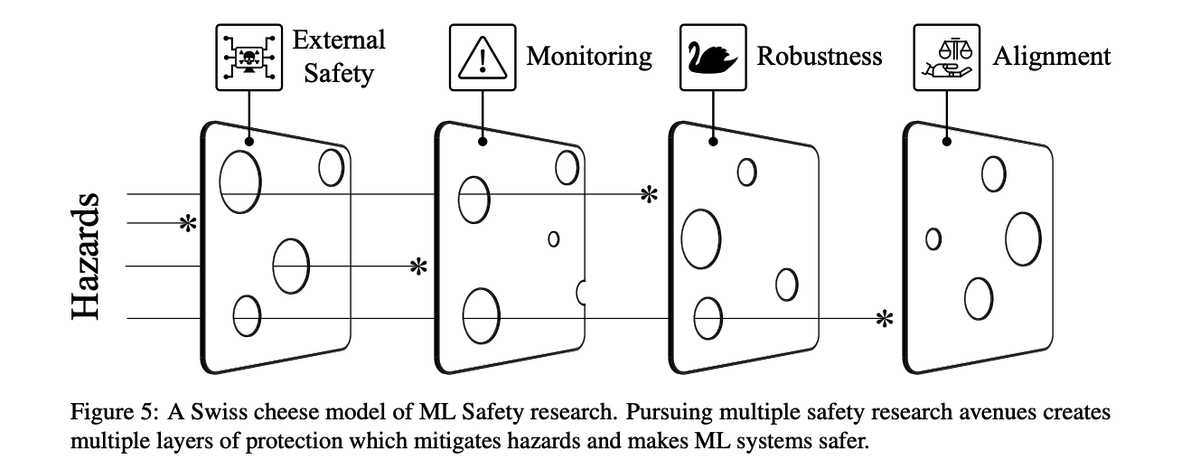

(图片引自Unsolved Problems in ML Safety)

- 产生原因:结构风险,不应忽略技术更为复杂和间接的影响(易被忽视)

- AI是否会改变政治、社会和经济结构,从而向决策者(甚至是善意和称职的决策者)施加压力,使其做出昂贵或冒险的选择。

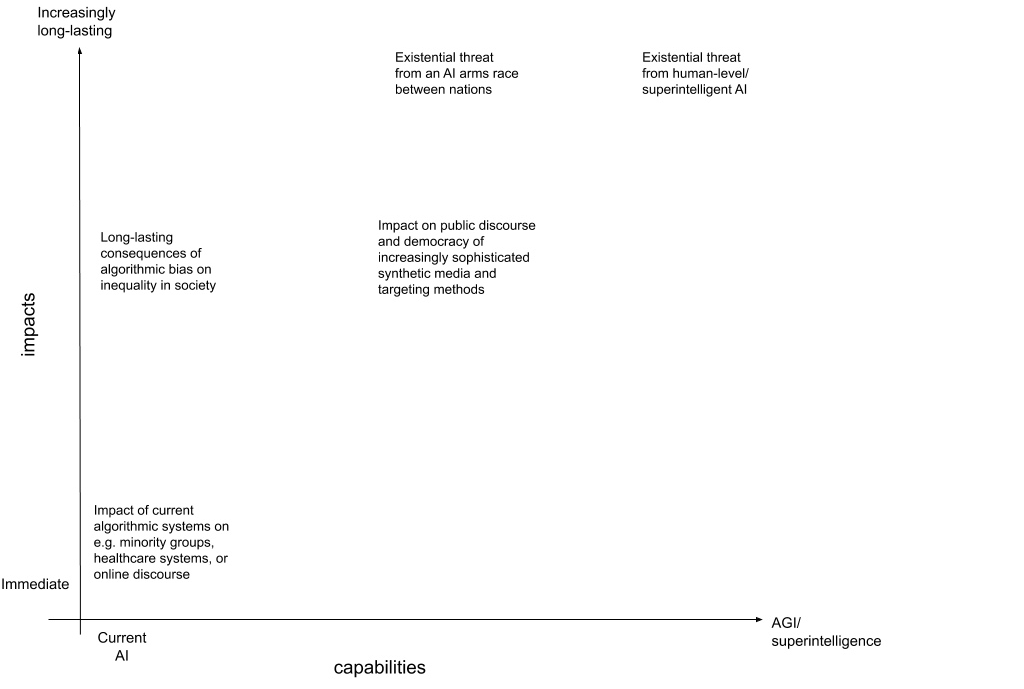

- 时间范围:近期 vs 远期

- 当我们讨论AI的不同时间段(近期和远期)影响时,是在讨论AI能力、持续时长、确定程度、影响程度的差别?(易被混淆)

- 似乎存在两个不同的研究社区,且在哪些问题最重要方面存在分歧。

- 近期阵营担心,对AGI/ASI的担忧分散了我们今天在人工智能方面面临的真正问题 X(其中 X = 算法偏差、技术失业、可解释性、数据隐私等)

- 长期阵营认为,他们关注的问题使得任何近期关注问题的重要性都相形见绌。

- 但这种二分法模糊了两者关心社会影响和积极应对风险的文化,以及在可解释性、对抗性等方面高度相关的目标(易被忽视)

- 持续时长:即时 vs 长期

- 长期风险因存在很多影响因素和不确定性,本身就是一个研究难点。

- 并不是非此即彼,一项技术即可能产生即时影响,同时也可能产生长期影响。(易被忽视)

- 如带有偏见的推荐算法,即时影响个人权益,长期固化社会偏见。

3.2 分析组合

-

确定程度 x 影响程度

- 讨论近期 vs 远期的一种分析组合

- 风险的动物隐喻:

- 灰犀牛:很有可能发生的大影响事件,若无视警告会扑面而来,隐喻「已知的已知」

- 房间里的大象:某件虽然明显却被集体视而不见,隐喻「已知的未知」(易被忽视)

- 黑天鹅:具有重大影响的意料之外的事件,隐喻「未知的未知」(易被忽视)

- 黑水母:环境变化水母堵塞发电站进水口是小变化导致大影响,隐喻「未知的已知」(易被忽视)

- 通常,焦点会被黑天鹅和房间里的大象所吸引,但黑水母同样值得关注。

(图片引自dayonefutures)

-

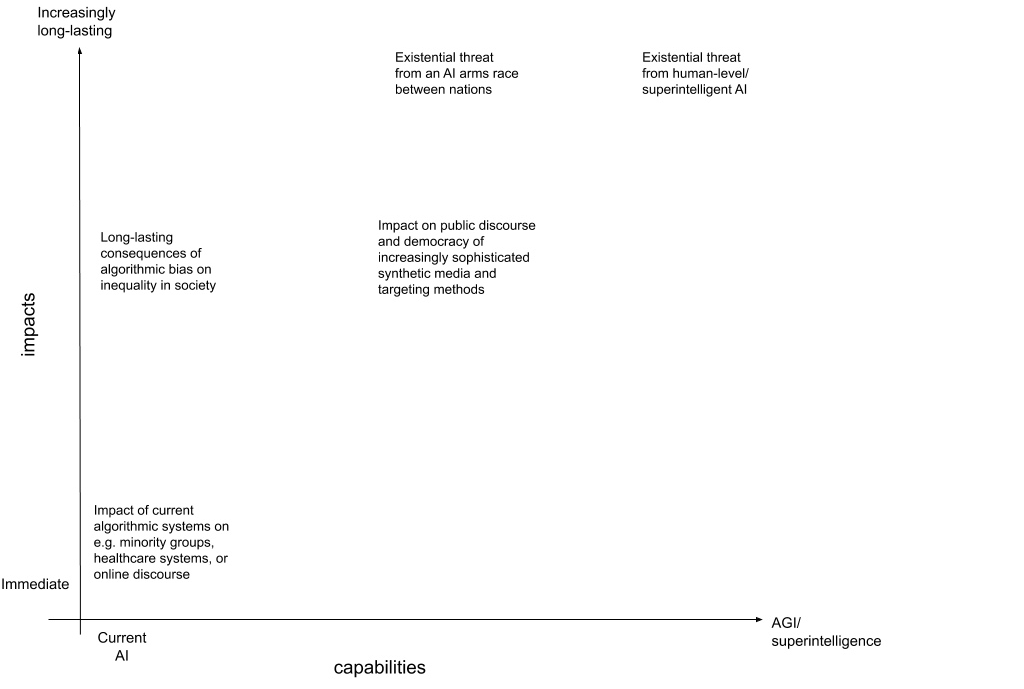

AI能力 x 持续时长

- 讨论近期 vs 远期的另一种分析组合(易被忽视)

- 机构关注点:

- AI Now(主要关注当前AI x 即时)

- FHI(主要关注长期,从中等AI的军备竞赛,到强AI的X-Risk等)

- CFI(广泛关注)

- 近中期AI能力的中长期影响(似乎更被忽视)

(图片引自Beyond near-and long-term: Towards a clearer account of research priorities in AI ethics and society)

- 持续时长 x 影响程度

- 讨论近期 vs 远期的再一种分析组合

- 持续积累的中小影响,也可能产生变革性(Transformative AI)(易被忽视)

- 如人类渐渐依赖机器进行决策

- 其中也隐含了对AI能力的讨论

4 建议

- 从研究的角度,在选择细分风险研究领域时,可结合自身能力、领域预判重要性、领域被忽视程度等角度综合分析。

- 从沟通的角度,在讨论AI风险时,建议明确表明自己所讨论的风险维度和潜在假设,以利于相互沟通和理解。

参考文献

[1] Remco Zwetsloot, and Allan Dafoe. “Thinking about risks from AI: accidents, misuse and structure. Lawfare.” (2019).

[2] Carina Prunkl, and Jess Whittlestone. “Beyond near-and long-term: Towards a clearer account of research priorities in AI ethics and society.” In Proceedings of the AAAI/ACM Conference on AI, Ethics, and Society, pp. 138-143. 2020.

[3] Miles Brundage, Shahar Avin, Jack Clark, Helen Toner, Peter Eckersley, Ben Garfinkel, Allan Dafoe et al. “The malicious use of artificial intelligence: Forecasting, prevention, and mitigation.” arXiv preprint arXiv:1802.07228 (2018).

[4] Pedro A. Ortega, Vishal Maini, and DeepMind Safety Team. “Building safe artificial intelligence: specification, robustness, and assurance.” DeepMind Safety Research Blog (2018).

……

18 May 2022

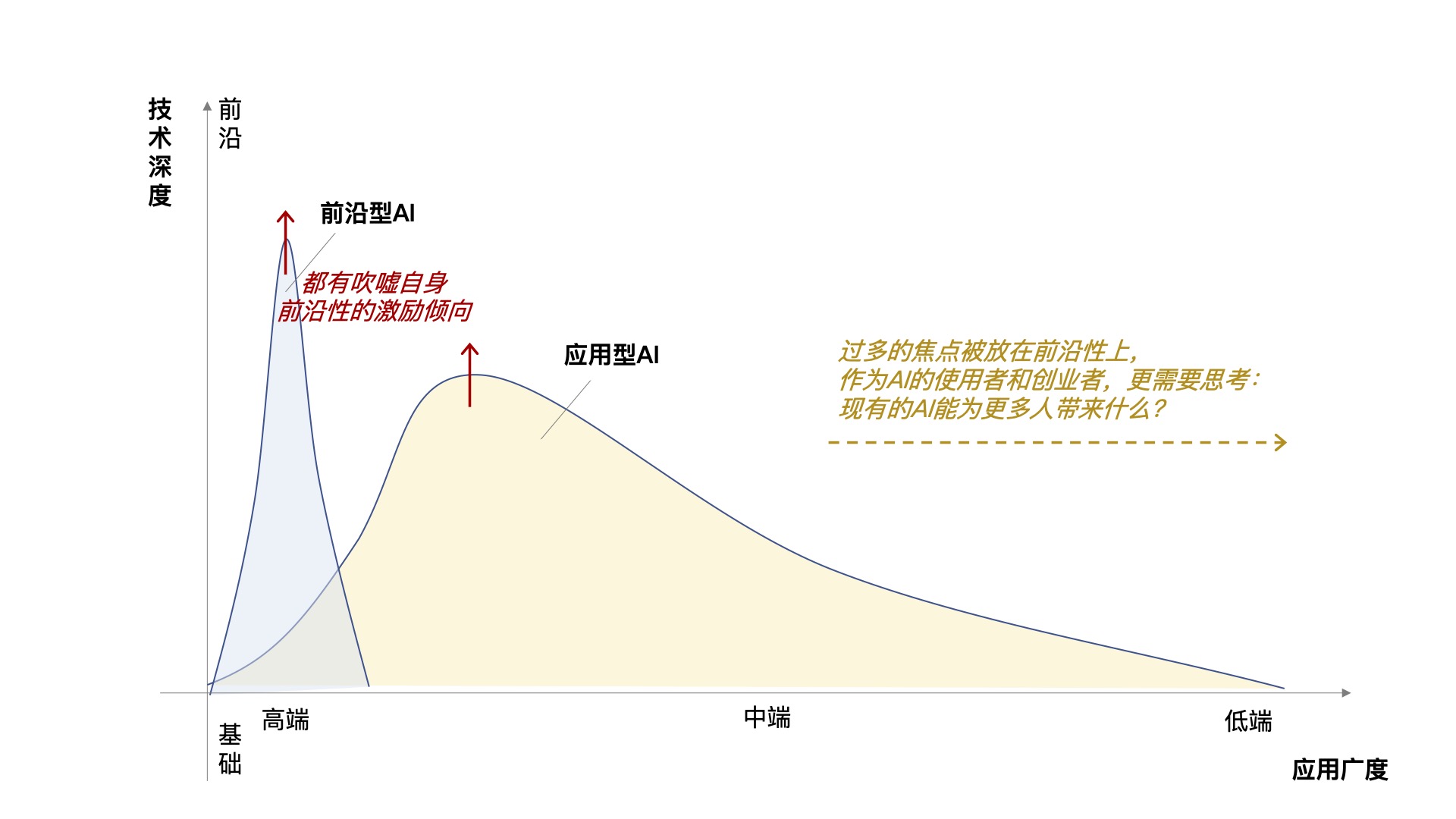

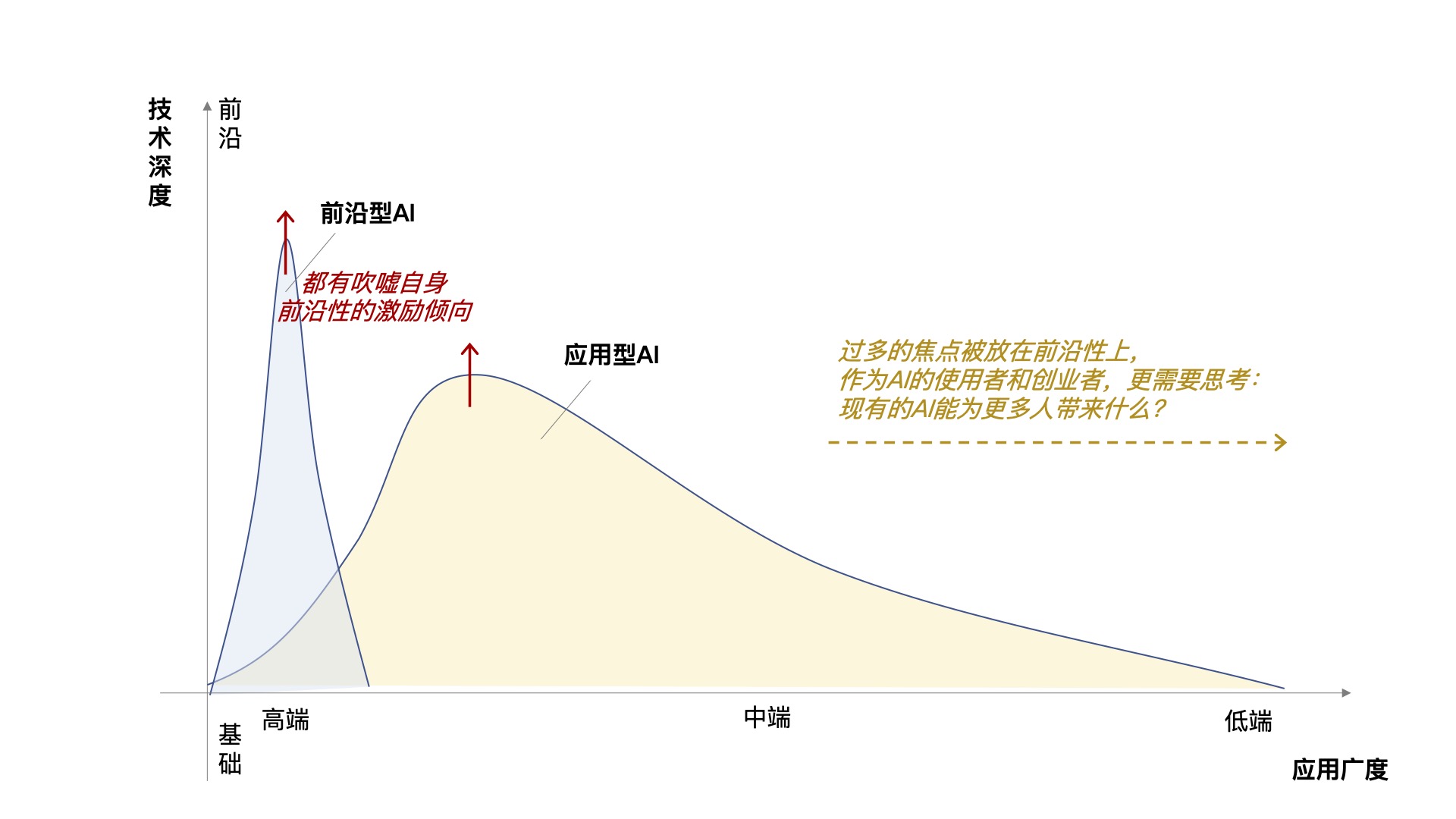

当今的AI领域存在两种主流的发展导向。

1 应用型AI(Applied AI):目标是发布具有现实影响力的产品

它在本质上是一种新的数据分析和查询方法。

就像数据库和SQL曾经给供应链、经营分析等商业场景带来了巨大变革,如今的所有企业都离不开各种数据库一样,此种AI类似一种更高效的SQL语言,可以:

-

对已有数据的已提出问题给出更好的结果,改进路线、投资组合等,如何实现进一步的优化?

-

对已有的数据提出新的问题,那些「异常」代表了什么,有哪些潜在机会?

-

开辟了新的可供分析的数据,从过去的结构化数据扩展到了音频、图像或视频等非结构化数据,计算机对其的「感知」越来越好,但也不再那么前沿,机器感知现实世界可以解决什么实际问题?

随着产业智能化的推进,应用型AI已经迅速扩展到各个领域。

「未来已来,只是分布不均」。

当前,科技企业更多将AI落地于商业化前景较好的领域。

与场景相结合,加强技术的可及性和易用性,是其中的关键。

2 前沿型AI(Frontier AI):目标是通过AI开拓新的领域与可能性

技术前沿是不断演进的,且变化得很快,如今我们早已不再对计算机单一的听说读写能力超越人类而感到惊叹。

GPT-3(语言模型/基础模型)、AlphaFold 2(蛋白质折叠/AI for Science)、DALL·E 2(文字生成图像/创意)等真正的前沿AI拓展了AI领域以及其他领域的可能性。(我看到它们的第一反应都是「哇塞」,你呢?)

正如DeepMind曾表示「其目标始终是构建最终能够解决现实世界中重要问题的通用学习系统……AI有望成为加速科学发现本身的强大工具。」蛋白质折叠、可控核聚变等的突破,体现了DeepMind选择「可突破的重大科学问题」的眼光相当敏锐,并带动「AI for Science」成为当前科技创新的一大热点领域。

但过多关于前沿技术,也有不利影响:

忽视AI的技术扩散,会吸走房间里面的氧气。从社会价值来讲,AI应该关注向最普通但收益最广人群的应用,并且多数时候这些场景都不需要应用到最前沿的AI。因此,目标使更多企业和群体的需求得到广泛关注,让每个人都能享受到数字技术的便利的「普惠AI」也成为当前科技创新的一个热词。特别面向是老人儿童等「弱势群体」,以及不同时期的「非常规群体」。

声称AI的超强表现,带来不切实际的期望。AI科学家Ken Church近期曾撰文对「追逐SOTA」(SOTA-Chasing)这一AI科研现状提出批评,强调竞争Benchmark排行榜分散了人们对该领域更重要机遇的注意力,并阻碍了跨学科合作。更危险的是「AI吹嘘」(Make-believe AI),目标是通过发布声称SOTA成果的论文和PR稿,让投资者、公众、学者相信你所做的事情很重要,让投资者、公众、学者相信你所做的事情很重要,这会造成一种有害的激励,不仅损害自身的职业生涯,也会将AI研究导向歧途,甚至导致又一个「AI寒冬」。

3 两者并非非黑即白,需保持合理的研发投入结构

应用型AI vs 前沿型AI,两者都有吹嘘自身前沿性的激励倾向,这一点不得不防。

几项建议:

- 从国家和行业的角度,需要加强自上而下的科研议题设定能力,也需要通过AI政策和法规等加以引导,如可借助AI治理工作进行推动。真正重要的前沿领域如AGI/AGI Safety,应保持一定的投入强度,避免被忽视。

- 从科技公司的角度,需要明确自身对AI发展的定位,两类AI都有价值,但需要做得扎实。技术向长尾的扩散,同样可能产生令人感到「哇塞」的应用,这种惊艳并非来自前沿技术,而是创意+知识+技术的结合。

- 从AI使用者和创业者的角度,虽然公众的注意力多数时候都被前沿型AI所吸引,但是我们更需要主动思考:现有的AI能为更多人带来什么?

最后我想问:对于虚拟人、L4自动驾驶、元宇宙,你会如何分类?

12 May 2022

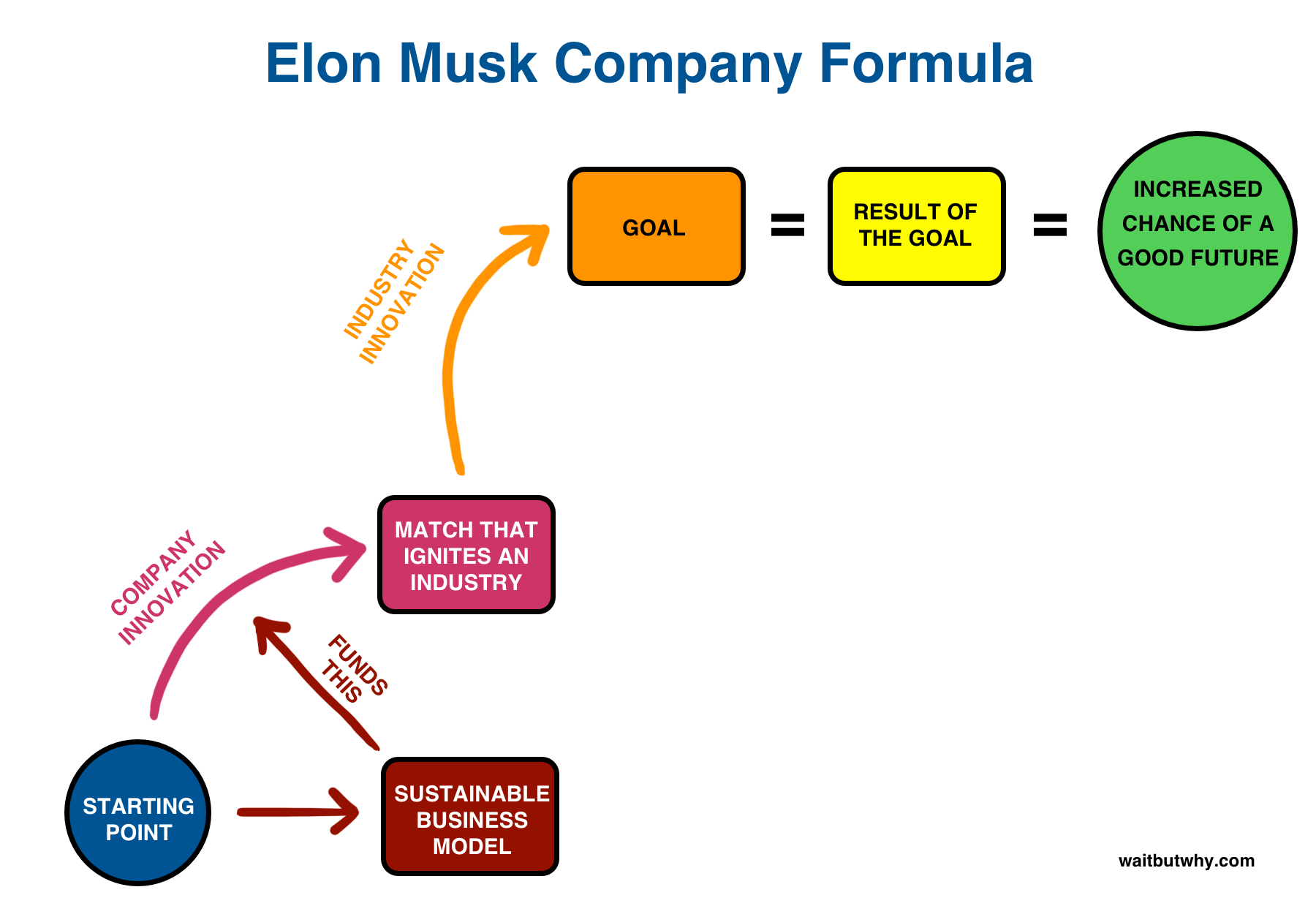

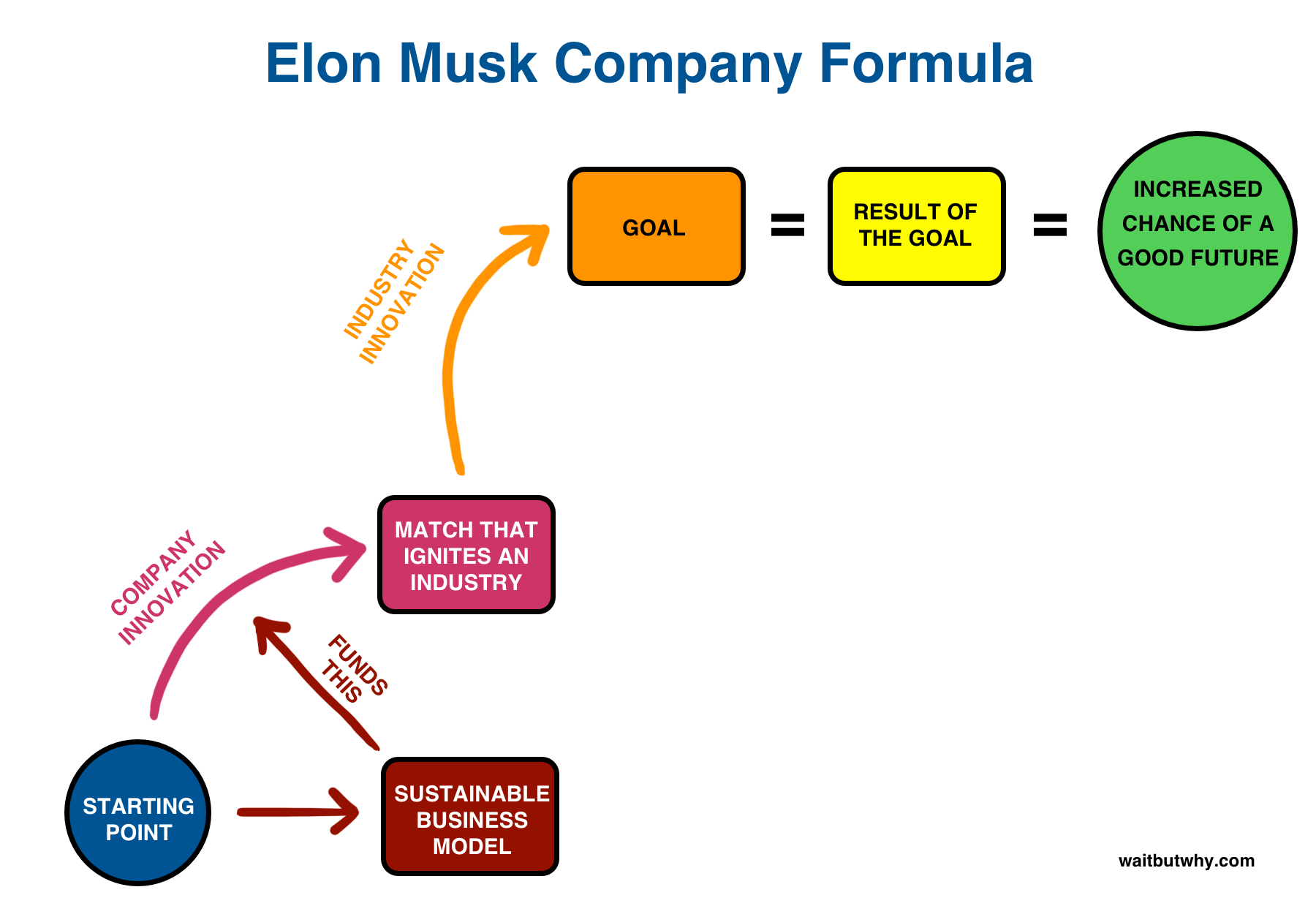

对于一个一直追求「下一代」的人来说,这次追求Twitter这一「上一代」绝对非比寻常,况且他还是当今世界的首富。

从他以往的一些言论,我们可以推测一下Twitter后续可能的改变和影响。

1 增加编辑按钮

今年4月初,在其提出收购Twitter的意向之前,他进行了一次网络投票,结果近74%的用户选择了支持「编辑按钮」。

Twitter也表态「正在考虑测试编辑按钮」,并表示:「但我们并不是根据用户调研决定的」。

2 减少机器人用户

在TED 2022大会上,Elon Musk表示,「我的首要任务是消除Twitter上的垃圾邮件、诈骗机器人和机器人大军,它们让产品变得更糟。」

之后他发推:「如果我们的Twitter竞标成功,我们将击败垃圾邮件机器人,否则将死去!」

Elon Musk表示,如果他的收购成功,他将撤销Twitter对前总统Donald Trump的禁令。

一方面,「在Twitter上禁止Trump并没有结束他的声音,它会在右翼群体内放大,因此它在道德上是错误的,而且完全是愚蠢的」。另一方面,「Twitter也不应该进行永久禁言」。

这对于Trump来说,可能是一个好消息,也将进一步搅动美国的证据,民主党中期选举将面临更大的舆论压力。

4 以言论自由的名义平衡舆论或弱化审查

Elon Musk曾说过:「Twitter 值得公众信任,它必须在政治上保持中立,这实际上意味着平等地使极右翼和极左翼感到不适」

在他看来,「Twitter显然有很强的左翼偏见。」

但Max Berger引用的报告则指出,「Twitter的每一项实证研究都显示出右翼偏见,右翼比左翼享有更大的算法放大率。」

考虑到Elon Musk极力主张言论自由,因此其接手Twitter后可能会使平台更接近他的理念。但同时,我也希望Twitter能像Improve the News一样对事实和观点做更好的区分。

Elon Musk没有明确表达过此意图,但私有化带来的副产品将使Twitter受更少的监管,管理团队决策的自由度更高,Twitter将不可避免的更多体现他们的意识形态。

对于Twitter这样有影响力的平台,这将对公共舆论和选举产生多大程度的影响有待观察。

由于担心Twitter黑盒算法中的事实偏见会对公共讨论产生重大影响,Elon Musk认为Twitter的算法应该开源。

他在TED大会上又进一步阐述,「 Twitter 应该做的一件事是开源算法,并且人对推文进行任何更改行为都应该是显而易见的……这样所有人都可以看到,将不会有幕后操作,无论是算法还是手动。」

这对于社交平台来说,是一个有益的尝试。同时,对于Twitter自己来说,也将减少对其存有政治偏见的指责。

7 增加会员服务,减少对广告的依赖

但这也意味着Twitter将面临更大的收入压力,多元化的变现手段将势在必行。

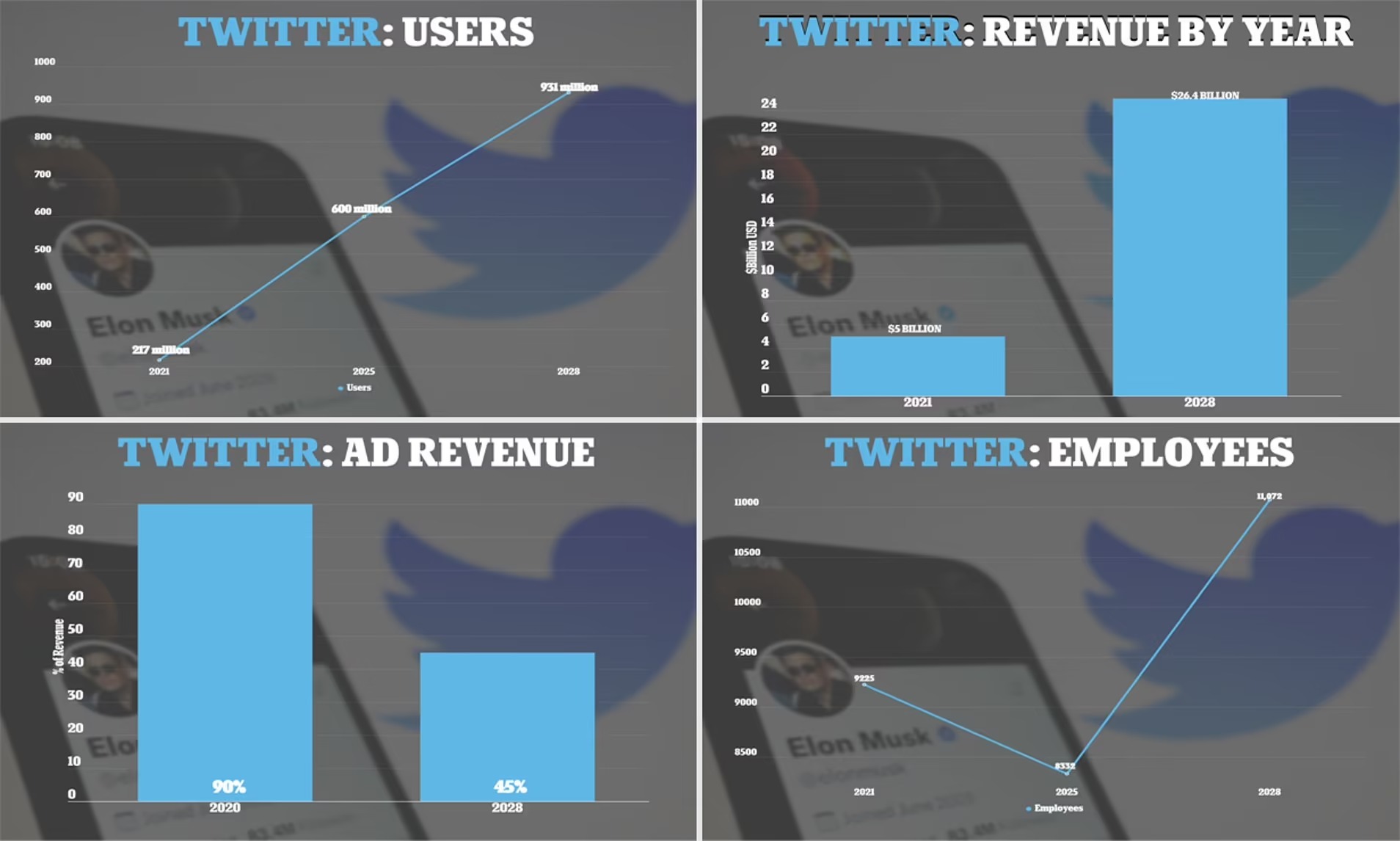

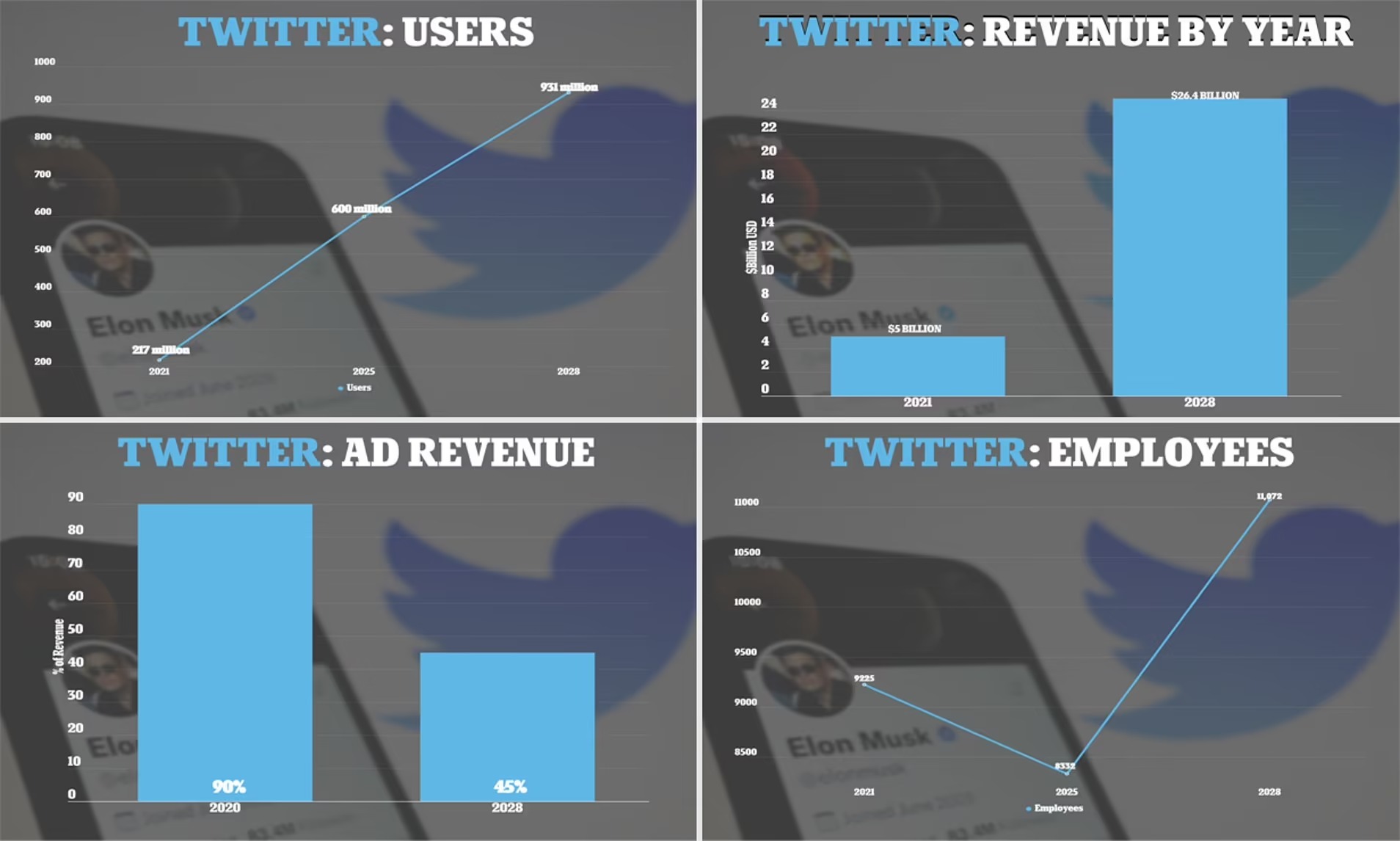

Elon Musk的构想,将把 Twitter 的年收入从去年的50亿美元增加到2028年的264亿美元,其中:

- 广告收入2028年将达到120亿美元,但比例将从2020年的90%降至45%;减少对于广告的依赖,将会使广告主对于Twitter舆论导向的影响降低,也是平衡话语权的关键举措之一。

- 付费会员成为第二曲线,Twitter Blue会员服务2028年将贡献100亿美元的收入,约占38%;提升举措包括:包括更便宜的订阅价格、去除广告和提供加密货币支付选项。

- 其他收入包括数据许可、打赏、购物等业务。

这个雄心勃勃计划的难点在于,如何扩大Twitter的用户群,使其成为/回归主流用户市场。Jack Dorsey二次回归Twitter时,也希望扩大用户群,但并未成功。

8 Project X

根据纽约时报报道,在Elon Musk的Twitter商业计划中,还提到了一个神秘的订阅制新产品「Project X」。

文档没有详细说明Project X是什么,但Elon Musk暗示将引入无广告体验,该产品将于2023年推出,预计第一年将有900万订阅用户,到 2028年将拥有1.04亿用户。

9 鼓励人们更广泛地思考人类的未来

Elon Musk以擅用「第一性原理」和「思考未来」著称,如果他能鼓励人们对人类未来进行更多思考和讨论,这无疑是有益的。

但如何处理与其商业帝国的利益相关性则是监管机构应该关注的。

如对碳中和议题的引导,涉及Tesla、SolarCity;对于太空探索议题的引导,涉及SpaceX等。在他就Tesla等工厂与各国政府的谈判时,Twitter很可能被用于营造对其有利的舆论形式。

10 推动AGI Safety研究

最后一点也和人类的未来相关,但我想单独强调。

Elon Musk一向关注AGI Safety,资助过Max Tegmark的Future of Life Institute、Nick Bostrom的Future of Humanity Institute等,也为分散AGI风险创办过OpenAI。

虽然没有明确消息表示他会利用Twitter更多引导AI风险的相关讨论,但我非常希望会如此。